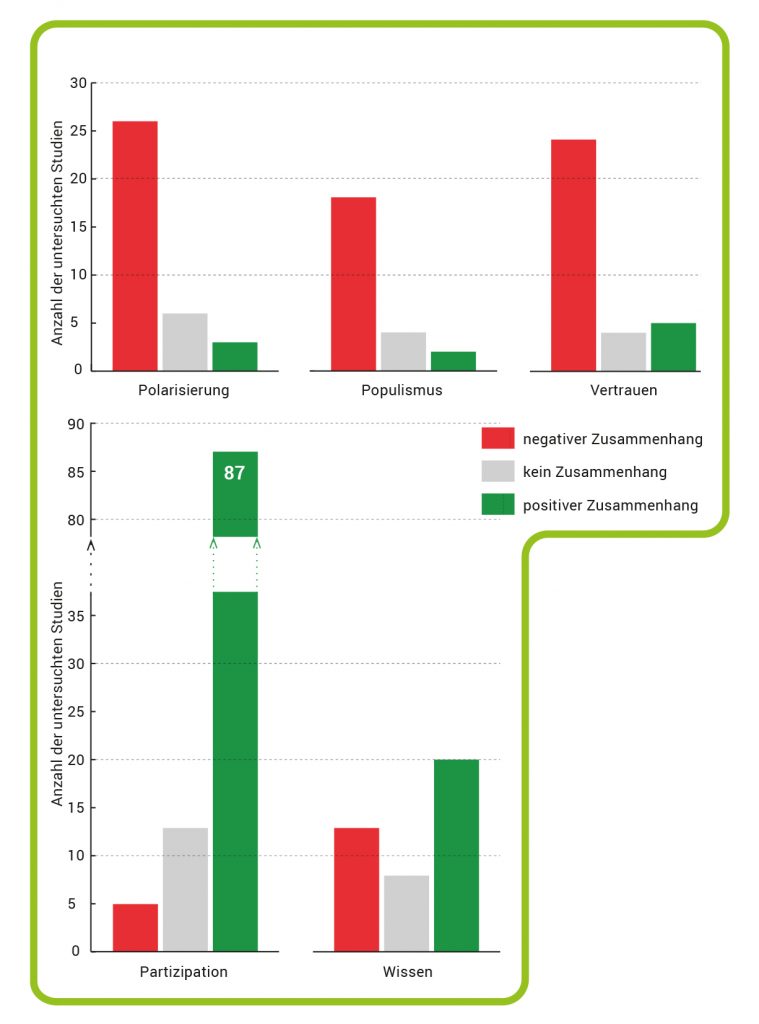

Eine Metaanalyse zeigt positive Effekte von sozialen Medien auf politisches Wissen und insbesondere die politische Partizipation. Gefahren für die Demokratie entstehen durch sinkendes Vertrauen in demokratische Institutionen, Populismus und politische Polarisierung.

© Quelle: Lorenz-Spreen, P., Oswald, L., Lewandowsky, S. et al. A systematic review of worldwide causal and correlational evidence on digital media and democracy. Nat Hum Behav 7, 74–101 (2023). https://doi.org/10.1038/s41562-022-01460-1; Grafik: HNBM // CC BY 4.0

Die Sammlung enthält Aufgaben zu folgenden Themen:

Keeling-Kurve / Das weltweite CO2-Budget / Umwandlung von Kohlenstoffsenken in -quellen / Einfluss von El Niño / Schutz von Kohlenstoffsenken

Unterrichtsmaterial zum Geomax 30

linker Button: Aufgabensammlung; rechter Button: Anlage (Arbeitsblatt zur Aufgabe 4)

Eine Schwächung der Nordatlantischen Umwälzzirkulation könnte bis zum Jahr 2100 Folgekosten von mehreren Billionen Euro verursachen, da weniger Kohlenstoffdioxid vom Ozean aufgenommen wird und sich das Klima weiter erhitzt. Die Forschung zeigt, dass frühere Studien die Folgen der Abschwächung der nordatlantischen Umwälzströmung wahrscheinlich unterschätzt haben. Denn die geringere CO2-Aufnahme durch die Ozeane könnte zu häufigeren und extremen Wetterereignissen führen.

[Dauer des Videos: 3 min]

YouTube-Link: https://youtu.be/BoNA-C7fFoI

Wer heute Informationen sucht, geht zuerst ins Internet. Warum auch nicht, hier wird schneller kommuniziert und jede Person kann selbst Inhalte bereitstellen – nie war es einfacher, andere für die eigene Sache zu mobilisieren. Aber ist das Ganze so demokratiefördernd, wie es scheint? Philipp Lorenz-Spreen vom Max-Planck-Institut für Bildungsforschung gibt Antworten zur Frage: Wie groß ist der Einfluss der sozialen Medien auf unseren gesellschaftlichen Diskurs und die politische Meinungs- und Willensbildung?

Videodatei | 13 min, März 2025

© MPG / CC BY-NC-ND 4.0

Soziale Medien sind heute ein fester Bestandteil unseres Alltags: Die ARD/ZDF-Medienstudie 2024 zeigt, dass in Deutschland immer mehr Menschen Social-Media-Angebote nutzen. 60 Prozent machen regelmäßig (mindestens einmal wöchentlich) von den verschiedenen Nutzungsmöglichkeiten Gebrauch (Abb. A). Die Plattformen sind dabei weit mehr als reine Unterhaltungsmedien: Die sozialen Netzwerke prägen den öffentlichen Diskurs mit – vom politischen Wahlkampf bis hin zu gesellschaftlich relevanten Debatten über Klimawandel, Migration oder LGTBIQ-Rechte.

Diesen Wandel spürt auch die Politik. Alle großen Bundesparteien sowie zahlreiche Spitzenpolitiker und -politikerinnen sind heute in den sozialen Medien aktiv und versuchen dort, ihre Botschaften an die Nutzerinnen und Nutzer zu bringen. Besonders auffällig ist hier: Gerade populistische Parteien sind auf Social Media besonders erfolgreich. Woran liegt das?

Abb. A: Nutzung von Social Media. Die ARD/ZDF-Medienstudie belegt, dass in Deutschland immer mehr Menschen soziale Medien nutzen. Die mindestens wöchentliche Nutzung hat sich im Jahr 2024 auf rund 60 Prozent erhöht. Der Anstieg um 8 Prozentpunkte seit 2023 ist vorranging auf die Altersgruppe der 50- bis 69-Jährigen zurückzuführen.

© Quelle Zahlen: ARD/ZDF-Medienstudie 2024; Grafik: HNBM

„Wir müssen uns bewusst machen, dass die sozialen Kanäle die Art und Weise, wie Informationen öffentlich vermittelt werden, grundlegend verändert haben“, sagt Lisa Oswald, die sich am Max-Planck-Institut für Bildungsforschung in Berlin mit politischer Kommunikation und öffentlichem Diskurs im digitalen Raum beschäftigt. „Früher hat die sogenannte ‚One-to-many-Kommunikation‘ den öffentlichen Diskurs bestimmt – also ein Sender vermittelt Informationen an viele Empfängerinnen und Empfänger“, erklärt sie. Ein klassisches Beispiel: Eine Zeitung oder ein TV-Sender berichtet für seine Leserschaft über ein bestimmtes Thema (s. Kasten). Dabei gelangen Informationen in die Öffentlichkeit, indem Journalistinnen und Journalisten sie vor Veröffentlichung recherchiert, strukturiert und durch mehrere Instanzen auf ihre Richtigkeit prüfen lassen. Diese Standards sorgen unter anderem dafür, dass die Anzahl falscher Meldungen reduziert wird. „Diese Art der Kommunikation führte auch dazu, dass wir als Gesellschaft eine gemeinsame Informationsbasis hatten, die weitgehend faktengetrieben und -geleitet war. Auf dieser Basis haben wir dann unterschiedliche Meinungen gebildet und ausdiskutiert“, so Oswald.

Für eine stabile Demokratie bot dieser öffentliche Diskurs eine solide Grundlage. Mit dem Aufstieg der sozialen Medien ist diese Form der Kommunikation jedoch nicht mehr die einzige. Sowohl die Formate als auch die Personen, die Informationen verbreiten, haben sich online vervielfältigt. Heute gibt es in den sozialen Medien viele Sendende, die Inhalte an zahlreiche Empfängergruppen vermitteln. Diese sogenannte „Many-to-Many-Kommunikation“ hat Vor- und Nachteile. Zum einen kann sie dazu führen, dass Menschen, die bisher im öffentlichen Diskurs untergingen, eine Stimme bekommen – zum Beispiel, wenn sie Teil einer marginalisierten Bevölkerungsgruppe sind. „Ein Problem ist es aber, wenn Menschen in den sozialen Medien nicht geprüfte Inhalte publizieren und zwischen Fakt und Meinung nicht unterscheiden“, sagt Oswald.

Um zu verstehen, warum negative Meldungen und Populismus online so gut funktionieren, muss man sich die Funktionsweise der Plattformen genauer anschauen. Soziale Netzwerke wie Facebook, Instagram oder TikTok werden von großen Unternehmen geführt. Als Player in der globalen Marktwirtschaft wollen diese zunächst einmal ihren Gewinn steigern. Diesen erzielen sie primär durch Werbeeinahmen. Die Währung dafür ist unsere Aufmerksamkeit: Je länger ein Mensch auf einer Plattform aktiv ist, desto mehr Werbung kann er konsumieren – und desto mehr Geld verdient das Unternehmen. Dieses Konzept nennt sich „Aufmerksamkeitsökonomie“. Um hier besonders gut abzuschneiden, designen die Unternehmen ihre Social-Media-Plattformen zum Beispiel so, dass Menschen sich möglichst ohne Reibungspunkte lange und gerne mit ihrem Feed beschäftigen. Hierfür werden bevorzugt Inhalte ausgespielt, die Aufmerksamkeit erregen, zum Beispiel besonders emotionale, aufregende oder negativ konnotierte Themen, die in kurzen, möglichst auffälligen und eingängigen Formaten präsentiert werden. Diese Funktionsweise begünstigt Populismus, Hate Speech und Polarisierung – Phänomene, die genau nach diesen Spielregeln funktionieren. So erklärt sich auch der überdurchschnittliche Erfolg populistischer Parteien in den sozialen Medien: „Kurze Formate, toxische Sprache und emotionale Botschaften werden durch den Algorithmus besonders gut ausgespielt und bekommen eine hohe Reichweite. Parteien, die eine differenzierte Lösung für ein komplexes Problem präsentieren wollen, haben es in den sozialen Medien schwerer als Populisten, die scheinbar einfache Antworten liefern“, erklärt Oswald.

Diese Verschiebung der öffentlichen Kommunikation kann weitreichende Folgen für die Demokratie haben. In einer großen Metastudie hat Lisa Oswald mit einem Team des Max-Planck-Instituts für Bildungsforschung, der Hertie School in Berlin und der University of Bristol untersucht, welche Effekte soziale Medien für die Demokratie in unterschiedlichen Ländern haben. Für die Studie haben die Forschenden rund 500 wissenschaftliche Veröffentlichungen ausgewertet, die über Umfragen oder Experimente zum Zusammenhang zwischen Demokratie und sozialen Medien berichtet haben. Ihr Ergebnis: Es gibt sowohl negative als auch positive Zusammenhänge zwischen sozialen Medien und politischen Faktoren (Abb. B).

Abb. B: Ambivalente Wirkung von Social Media. Eine Metaanalyse zeigt positive Effekte von sozialen Medien auf politisches Wissen und insbesondere die politische Partizipation. Gefahren für die Demokratie entstehen durch sinkendes Vertrauen in demokratische Institutionen, Populismus und politische Polarisierung.

© Quelle: Lorenz-Spreen, P., Oswald, L., Lewandowsky, S. & Hertwig, R.: A systematic review of worldwide causal and correlational evidence on digital media and democracy. Nat Hum Behav 7, 74–101 (2023). https://doi.org/10.1038/s41562-022-01460-1; Grafik: HNBM // CC BY 4.0

Als besonders positiv stellte sich heraus, dass sich durch soziale Medien mehr Menschen am politischen Diskurs beteiligen – soziale Netzwerke steigern also die politische Partizipation. Das liege vor allem daran, dass es online geringere Hürden für Partizipation gebe, erklärt Oswald. Musste man früher etwa mit Papier und Stift durch die Fußgängerzone laufen, um Menschen dazu zu bewegen, eine Petition zu unterschreiben, funktioniert das heute online mit wenigen Klicks. Außerdem hat sich in den sozialen Medien eine neue Form des Aktivismus‘ entwickelt, der sogenannte „Hashtag-Activism“. Dazu zählen Phänomene wie die #metoo-Bewegung oder das #blacklivesmatter-Movement. „Diese Form von Aktivismus wurde anfangs zwar etwas belächelt, aber man hat gesehen, dass sie weitreichende politische Konsequenzen ausgelöst hat“, sagt Lisa Oswald. Besonders in autokratischen Systemen, in denen es mitunter lebensgefährlich sein kann, für Proteste auf die Straße zu gehen, hätten die sozialen Medien eine Tür für ziviles Engagement geöffnet. Zudem können digitale Medien politisches Wissen fördern und für ein vielfältigeres Nachrichtenangebot sorgen. Ein kleinerer Teil der untersuchten Veröffentlichungen belegt aber auch negative Auswirkungen auf politisches Wissen, beispielsweise durch den Effekt „News-Finds-Me“: So tendieren Social-Media-Nutzende dazu, sich nicht mehr aktiv zu informieren, da sie davon ausgehen, dass wichtige Informationen sie automatisch erreichen.

Vor allem bei drei Faktoren konnten die Forschenden Gefahren für die Demokratie nachweisen: Die Nutzung sozialer Medien hängt negativ mit Vertrauen in demokratische Institutionen und Prozesse zusammen, der Zulauf für populistische Meinungen steigt und die politische Polarisierung nimmt zu. Die Ursachen hierfür sind noch nicht genau erforscht. Es wurde lange das Phänomen diskutiert, dass sogenannte Echokammern die Probleme verstärken. Dabei unterscheiden Forschende allerdings zwei Formen: „Soziale Echokammern, also dass Menschen sich online gerne mit Gleichgesinnten umgeben, sind nachgewiesen“, erklärt Oswald. Dieses Phänomen sehen wir aber auch in anderen sozialen Kontexten. „Die zweite Variante ist die Annahme, dass man online nur noch Dinge konsumiert, die der eigenen Meinung entsprechen und diese verstärken. Das konnte bisher nicht klar nachgewiesen werden“, sagt die Wissenschaftlerin.

Digitale Medien können bestehende Demokratien bedrohen, denn „wenn das Vertrauen in die Spielregeln der Demokratie sinkt, ist das sehr gefährlich“, sagt Lisa Oswald. Politische Diskurse könnten in einer funktionierenden Demokratie zwar durchaus hart geführt werden, doch sobald Menschen anzweifelten, dass die Justiz oder das Parteiensystem prinzipiell funktionieren, entstünden Probleme. Ein erschreckendes Beispiel dafür, welche Folgen dieses Misstrauen haben kann, ist der Sturm auf das Kapitol in Washington nach der verlorenen US-Wahl von Donald Trump im Jahr 2020. Dabei verschafften sich Anhänger des damals noch amtierenden Präsidenten gewaltsam Zugang zum Kongress der Vereinigten Staaten, um den Senat und das Repräsentantenhaus daran zu hindern, die Wahlniederlage Trumps förmlich zu bestätigen. Koordiniert wurde dieser Angriff unter anderem in den sozialen Medien. Der Vorfall zeigt auch, wie leicht die Meinungspolarisierung aus sozialen Medien in die Offline-Welt überschwappen kann.

„Unterschiedliche Meinungen sind für die Demokratie grundsätzlich kein Problem“, sagt Lisa Oswald. „Kritisch wird es erst, wenn man anfängt, Menschen, die anders denken, nicht mehr zu respektieren. Das ist für die Demokratie gefährlich.“ Dahinter steht die sogenannte affektive Polarisierung. Dabei zeigen Personen eine große, generelle Antipathie gegenüber ganzen Gruppen, zum Beispiel politisch Andersdenkenden – unabhängig davon, zu welchem inhaltlichen Thema sich die Gruppe äußert.

Es gibt einige Mechanismen und Hinweise, dass soziale Medien Demokratien gefährden können – und Ansätze, dem entgegenzuwirken: Mit einem kritischen Blick können Nutzerinnen und Nutzer falsche Informationen und Polarisierung besser erkennen und die Kommunikation in den sozialen Netzwerken hinterfragen. „Die Plattformen erwecken schnell den Eindruck, dass die dort geteilten Inhalte der Mehrheitsmeinung entsprechen“, so Lisa Oswald. „Studien haben aber gezeigt, dass eigentlich nur verhältnismäßig wenige Menschen online Inhalte teilen – und das sind vor allem Personen mit einem hohen politischen Interesse und eher radikalen Ansichten. Das ist also keineswegs der Durchschnitt der Gesellschaft.“ Ein erster Schritt ist es daher, sich diese Verzerrung bewusst zu machen. Oswald rät außerdem, sich online an Accounts zu orientieren, hinter denen Menschen stehen, die nach journalistischen Standards arbeiten. „Es ist wirklich schwierig, alle Fakten in einem Beitrag selbst zu checken. Falsche Inhalte wirken oft glaubwürdig, und es erfordert viel Know-How und Zeit, alles zu überprüfen.“

Wie Nutzerinnen und Nutzer sich in sozialen Medien sicherer bewegen können, untersucht auch Anastasia Kozyreva. In ihrem Projekt am Max-Planck-Institut für Bildungsforschung hat sie Methoden unter die Lupe genommen, die falsche Informationen aufdecken und ihnen entgegenwirken. Widerlegungsstrategien sollen dem Einzelnen helfen, Falschinformationen zu erkennen. Eine der am besten erforschten Strategien ist das sogenannte „Debunking“. Fact-Checker oder Expertenteams stellen dabei nicht nur korrekte Informationen zur Verfügung, sondern erklären auch, warum eine Information falsch oder irreführend ist.

Großes Potenzial sieht Kozyreva im sogenannten Boosting. Dabei geht es darum, Personen in ihrer eigenen Verantwortung und Kompetenz zu stärken. „Menschen zum Beispiel durch Strategien zum Fact-Checking zu boosten, ist ein wichtiger Schutz vor falschen Informationen“, so Kozyreva. Eine Technik ist beispielsweise das „laterale Lesen“. „In einer Untersuchung der Stanford University wurden professionelle Fact-Checker, Lehrende und Studierende der Universität gebeten, eine Website daraufhin zu prüfen, ob ihre Inhalte vertrauenswürdig sind. Der beste Weg: Statt auf der Seite selbst durch kritisches Denken nach Spuren zu suchen, kopierten die Fact-Checker den Namen des Unternehmens einfach in eine Suchmaschine und haben es dort auf seine Vertrauenswürdigkeit überprüft“, erklärt Kozyreva. So seien sie schnell an zuverlässige Informationen gekommen.

Nudging ist eine Methode, um das Verhalten von Menschen zu beeinflussen, ohne dass dabei konkret etwas verboten wird. Die Idee: Kleine Veränderungen in der Gestaltung der Umwelt führen dazu, dass Personen Entscheidungen treffen, die besser für sie und die Gesellschaft sind. Ein klassisches Beispiel ist die Präsentation von abschreckenden Warnhinweisen auf Zigarettenschachteln, um den Konsum einzuschränken. Solche Nudges können auch in den sozialen Medien helfen: Plattformen könnten zum Beispiel kleine Stolpersteine einbauen, um die Userinnen und User dazu zu bewegen, beim Scrollen, Teilen und Liken innezuhalten und sie daran zu erinnern, wie wichtig es ist, nur korrekte Informationen zu teilen. Zum Beispiel könnte eine Nachfrage erscheinen, ob ein Inhalt wirklich geteilt werden soll, wenn er vorab gar nicht gelesen worden war. „Das Nudging-Konzept hat aber auch Risiken“, schränkt die Wissenschaftlerin ein. „Zum Beispiel findet kein Lerneffekt oder Empowerment bei den Menschen statt: Hat ein ‚Nudge‘ das Verhalten von Menschen verändert, fallen sie wieder zurück in alte Muster, sobald er entfernt wird.“

Nicht nur der Einzelne trägt mit seinem Verhalten zu einer sicheren und positiven Debattenkultur bei, es kommt auch auf die Betreiber der Plattformen an. Innerhalb der Europäischen Union bildet der Digital Services Act dafür den rechtlichen Rahmen. Das Regelwerk schützt die Grundrechte der Internet-Nutzenden und erleichtert die Entfernung illegaler Inhalte wie Hassrede und gefälschte Produkte. Gleichzeitig braucht es einen gesamtgesellschaftlichen Diskurs über die Entwicklung unserer Online-Welt: Welche Sicherheitsstandards für den sozialen Diskurs wollen wir etablieren? Wie können demokratische Prinzipien auf die Plattformen übertragen werden? Und wie kann eine konstruktive Diskussion in den sozialen Medien ablaufen?

Abbildungshinweise:

Titelbild: © master1305 / Adobe Stock

Abb. A: © Quelle Zahlen: ARD/ZDF-Medienstudie 2024; Grafik: HNBM

Kasten: © MPG; Grafik: HNBM // CC BY-NC-SA 4.0

Abb. B: © Quelle: Lorenz-Spreen, P., Oswald, L., Lewandowsky, S. & Hertwig, R.: A systematic review of worldwide causal and correlational evidence on digital media and democracy. Nat Hum Behav 7, 74–101 (2023). https://doi.org/10.1038/s41562-022-01460-1; Grafik: HNBM // CC BY 4.0

Der Text wird unter CC BY-NC-SA 4.0 veröffentlicht.

GEOMAX Ausgabe 31, März 2025; Text: Sabine Fischer; Redaktion: max-wissen-Team

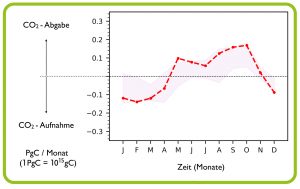

Die gestrichelte rote Linie zeigt den zeitlichen Verlauf der CO2-Aufnahme bzw. -Abgabe des Amazonasgebiets für das Jahr 2023. Der schattierte Bereich gibt die normalen Werte der letzten zwei Jahrzehnte (2003-2023) an. Die gestrichelte schwarze Linie ist die Netto-Null-Linie, d.h. CO2-Aufnahme und -Abgabe sind ausgeglichen. Von Januar bis April 2023 war die Kohlenstoffaufnahme höher als üblich. Das änderte sich im Mai, als der Regenwald begann, mehr CO2 freizusetzen, wobei die höchsten Werte im Oktober gemessen wurden. Da die CO2-Emissionen durch Brände innerhalb der normalen Werte der letzten zwei Jahrzehnte lagen, führen die Forschenden die Anomalie auf eine verringerte CO2-Aufnahme durch den Regenwald zurück.

© S. Botía, MPI für Biogeochemie / CC BY 4.0

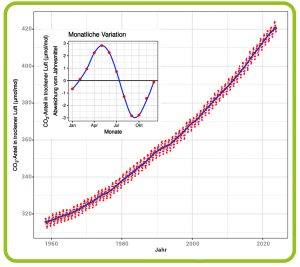

Im Jahr 1958 installierte der amerikanische Chemiker Charles D. Keeling ein Messgerät für Kohlenstoffdioxid (CO2) auf dem Vulkan Mauna Loa auf der Insel Hawaii. Das Gerät stand in rund 3.400 Metern Höhe, weit weg von störenden CO2-Quellen wie Industriegebieten. Keeling wollte den CO2-Gehalt der Atmosphäre bestimmen. Bis dahin gab es dazu nur ungenaue und widersprüchliche Daten. Daher war unklar, ob sich das Treibhausgas durch das Verbrennen von Öl, Gas und Kohle in der Atmosphäre anreichert. Viele Forschende vermuteten, das dabei freigesetzte CO2 würde vom Ozean geschluckt. Die vom Menschen verursachte Erderwärmung war damals bloß eine Theorie.

Keeling machte zwei Entdeckungen: Zum einen stellte er fest, dass die CO2-Konzentration innerhalb eines Jahres schwankt und dem Vegetationszyklus auf der Nordhalbkugel folgt: Im Frühjahr und Sommer nimmt sie ab, während sie in der kälteren Jahreshälfte ansteigt. Zum anderen konnte er bald nachweisen, dass der durchschnittliche CO2-Gehalt in der Lufthülle der Erde tatsächlich von Jahr zu Jahr zunimmt. Die von Keeling begonnene und bis heute fortgesetzte Messreihe gilt als bedeutendster Umweltdatensatz des 20. Jahrhunderts (Abb. A). Sie zeigte zum ersten Mal, wie die Biosphäre im Rhythmus des jahreszeitlich bedingten Pflanzenwachstums CO2 aus der Atmosphäre aufnimmt und wieder abgibt – und wie der Mensch das Klima des Planeten beeinflusst.

Abb. A: Keeling-Kurve. Die Abbildung zeigt die monatliche durchschnittliche CO2-Konzentration der Luft, gemessen auf dem Mauna Loa in einer Höhe von 3.400 Metern in den nördlichen Subtropen. Die Keeling-Kurve steigt nicht gleichförmig an, sondern schwingt im Verlauf des Jahres auf und ab. Jeweils am Ende des Frühjahrs klettert der Wert auf einen neuen Höchststand. Das liegt unter anderem daran, dass die Wälder der Nordhemisphäre im Winter nur wenig Fotosynthese betreiben und monatelang kaum CO2 aus der Luft aufnehmen, während Pflanzen und Böden einen Teil des zuvor aufgenommenen Kohlenstoffdioxids durch die Atmung wieder an die Atmosphäre abgeben. Der langfristige Trend hingegen geht hauptsächlich auf die anthropogen bedingten CO2-Emissionen zurück.

© Author: Oeneis; Data from Dr. Pieter Tans, NOAA/ESRL and Dr. Ralph Keeling, Scripps Institution of Oceanography / CC BY-SA 4.0

Vor Beginn der Industrialisierung herrschte zwischen Aufnahme und Freisetzung von Kohlenstoffdioxid im langfristigen Mittel ein Gleichgewicht. Der Mensch aber stört diese Balance, vor allem durch die Nutzung fossiler Rohstoffe, die heutzutage fast 90 Prozent der weltweiten Treibhausgasemissionen verursacht. Die restlichen zehn Prozent gehen auf das Konto veränderter Landnutzung. Dazu zählen die Umwandlung von Wäldern, Grasländern oder Mooren in landwirtschaftliche Nutzflächen und die Verwendung von Holz als Brennstoff, aber auch Siedlungs- und Straßenbau. Zu Beginn der industriellen Revolution waren die daraus resultierenden Emissionen sogar größer als jene aus dem Verbrennen fossiler Rohstoffe. Erst im Zuge des starken weltweiten Wirtschaftswachstums nach Ende des Zweiten Weltkriegs wurden Öl, Gas und Kohle zur bedeutendsten CO2-Quelle.

Die Erderwärmung durch die anthropogenen CO2-Emissionen wäre heute noch viel höher, gäbe es keine Ökosysteme, die einen Teil des Kohlenstoffdioxids aus der Atmosphäre aufnehmen und speichern. Wie das funktioniert und welche Faktoren dabei eine Rolle spielen, untersucht das Team von Sönke Zaehle, Direktor am Max-Planck-Institut für Biogeochemie in Jena. Die Wissenschaftlerinnen und Wissenschaftler erforschen die Kohlenstoffbilanzen von Landökosystemen. Sie wollen verstehen, wie etwa Wälder, Grasländer und Böden als Quellen und Senken von Treibhausgasen wirken und wie der Mensch und das Klima diese Ökosysteme beeinflussen. „In den vergangenen 60 Jahren haben Ozeane und Landökosysteme etwa die Hälfte der anthropogenen Kohlenstoffdioxid-Emissionen aus der Atmosphäre aufgenommen“, erklärt Sönke Zaehle (Abb. B). „Die Weltmeere nehmen Kohlenstoffdioxid aus der Atmosphäre auf und lösen es in Form von Kohlensäure. Auf dem Land wirken Pflanzen und Böden als Kohlenstoffspeicher.“ Die Forschung von Sönke Zaehle ist Teil eines globalen Monitorings: Klimaforschende aus der ganzen Welt erstellen jedes Jahr eine Bilanz des globalen Kohlenstoffkreislaufs. Sie beziffern im Global Carbon Report unter anderem die anthropogenen CO2-Emissionen auf der einen sowie die CO2-Aufnahme der Landbiosphäre und der Ozeane auf der anderen Seite.

Abb. B: Globales Kohlenstoffbudget 2023. Etwa die Hälfte des ausgestoßenen CO2 aus fossilen Energiequellen und Landnutzungsänderungen wird von Land- und Ozeansenken absorbiert, der Rest verbleibt in der Atmosphäre und trägt zum Klimawandel bei.

© Global Carbon Project; Data source: Friedlingstein et al. 2023 Global Carbon Budget 2023. Earth System Science Data. // CC BY 4.0; https://globalcarbonatlas.org

Bis heute gibt es noch keine Technologien, um Kohlenstoffdioxid in großem Maßstab aus der Atmosphäre zu entfernen. Um den Klimawandel einzudämmen, sind die natürlichen Senken daher von zentraler Bedeutung, denn ohne diese würde die doppelte Menge an CO2 in die Atmosphäre gelangen und die Erde noch schneller aufheizen. Doch die Senken sind zunehmend bedroht – durch menschliche Aktivitäten und auch durch den Klimawandel selbst. Im schlimmsten Fall kann die CO2-Abgabe die Aufnahme sogar übersteigen, sodass Pflanzen und Böden zur Netto-CO2-Quelle werden (s. Geomax 25). Das passierte etwa im Jahr 2023 – bis dahin das heißeste jemals aufgezeichnete Jahr, als die Netto-Kohlenstoffaufnahme an Land zeitweise sogar zusammenbrach: Pflanzen und Böden wandelten sich von Kohlenstoffsenken in -quellen.

Menschliche Aktivitäten wie Abholzung, Brandrodung oder die Trockenlegung von Feuchtgebieten, 2020 aber auch Urbanisierung und die Versiegelung von Böden zerstören wertvolle Kohlenstoffspeicher. Der Klimawandel fördert Hitze, Dürren, Brände und Überschwemmungen, die das Pflanzenwachstum beeinträchtigen und CO2 aus dem Boden freisetzen. Die weltweite landwirtschaftliche Nutzfläche beträgt heute rund fünf Milliarden Hektar – fast 40 Prozent der globalen Landoberfläche. Insbesondere in den Tropen und in anderen Ländern mit starkem Bevölkerungs- und Wirtschaftswachstum haben Landwirtschaft und Holznutzung stark zugenommen. So geraten die natürlichen Kohlenstoffreservoirs immer mehr unter Druck. In Südostasien werden Wälder vor allem für den Anbau von Ölpalmen und Kautschukbäumen großflächig gerodet, in Westafrika für Kakaoplantagen. Im Amazonasgebiet gilt die Produktion von Rindfleisch, Soja und Zuckerrohr als Haupttreiber der Entwaldung (s. Geomax 24).

Forschungsgruppenleiter Santiago Botía und sein Team am Max-Planck-Institut für Biogeochemie konzentrieren sich unter anderem auf den Amazonas-Regenwald, der mehr als die Hälfte des weltweit noch verbliebenen tropischen Regenwalds ausmacht. Die Forschenden möchten herausfinden, welche Rolle der Wald als Kohlenstoffsenke spielt, was seine Speicherkapazität beeinflusst und welche Prozesse sich auf den Gehalt von CO2, Methan und Lachgas in der Atmosphäre auswirken. Um die Kohlenstoffflüsse nachzuverfolgen, kombinieren sie Messungen von Treibhausgasen an Bodenstationen oder per Flugzeug mit Computersimulationen, die den Gastransport in der Atmosphäre abbilden. Wichtige Messdaten liefert das 325 Meter hohe Amazon Tall Tower Observatory (ATTO) mitten im brasilianischen Regenwald (s. Titelbild). Ziel ist es, Quellen und Senken von Kohlenstoff im Amazonasgebiet zu bestimmen.

„Grundsätzlich gilt der Amazonas-Regenwald als Kohlenstoffsenke“, sagt Santiago Botía, „Doch es gibt Hinweise, dass diese Senke durch menschliche Eingriffe sowie klimabedingten Trockenstress schwächer geworden ist.“ Eine wichtige Rolle dabei spielt El Niño (s. Kasten). El Niño ist ein natürliches Klimaphänomen, das die Folgen des menschengemachten Klimawandels wie Hitzewellen, Dürren oder extreme Niederschläge verstärken kann. Botía und sein Team haben gezeigt, dass die Dürre im Jahr 2023 das Pflanzenwachstum und damit die Kohlenstoffspeicherung beeinträchtigt hat (Abb. C): „Während eines El Niño wird insbesondere in den Tropen weniger Kohlenstoff gebunden und infolgedessen ist der CO2-Anstieg in der Atmosphäre in der Regel höher als in anderen Jahren“, sagt der Max-Planck-Forscher. Als weiteres Beispiel nennt er den starken El Niño in den Jahren 2015 und 2016. „Damals gab es viele Feuer, die zahllose Bäume vernichtet haben, zusätzlich hat der Wald wegen Hitze und ausbleibender Regenfälle weniger CO2 aufgenommen.“

Abb. C: Wenn der Regenwald zur CO2-Quelle wird. Die gestrichelte rote Linie zeigt den zeitlichen Verlauf der CO2-Aufnahme bzw. -Abgabe des Amazonasgebiets für das Jahr 2023. Der schattierte Bereich gibt die normalen Werte der letzten zwei Jahrzehnte (2003-2023) an. Die gestrichelte schwarze Linie ist die Netto-Null-Linie, d.h. CO2-Aufnahme und -Abgabe sind ausgeglichen. Von Januar bis April 2023 war die Kohlenstoffaufnahme höher als üblich. Das änderte sich im Mai, als der Regenwald begann, mehr CO2 freizusetzen, wobei die höchsten Werte im Oktober gemessen wurden. Da die CO2-Emissionen durch Brände innerhalb der normalen Werte der letzten zwei Jahrzehnte lagen, führen die Forschenden die Anomalie auf eine verringerte CO2-Aufnahme durch den Regenwald zurück.

© S. Botía, MPI für Biogeochemie / CC BY 4.0

Dass El Niño dabei auch zu Veränderungen der jährlichen Wachstumsrate des CO2-Gehalts in der Atmosphäre führen kann, belegt eine gemeinsame Studie von Forschenden des Max-Planck-Instituts für Biogeochemie und der Universität Leipzig: Langzeitdaten hatten gezeigt, dass der CO2-Gehalt in der Atmosphäre zwischen 1959 und 2011 phasenweise besonders stark angestiegen war. Als Ursache vermutete man langfristige klimabedingte Veränderungen des Kohlenstoffkreislaufs und damit des globalen Klimasystems. Die Forschenden überprüften diese Annahme anhand von Computersimulationen – und kamen zu einem anderen Ergebnis: Der hohe Anstieg lässt sich allein mit dem vermehrten Auftreten von El Niño-Ereignissen in den 1980er- und 1990er-Jahre erklären. Hierunter fallen auch die extremen El Niño-Phasen von 1982/83 und 1997/98, die starke Dürren und Hitzewellen in den Tropen mit sich brachten. Während dieser Phasen nahm der CO2-Gehalt in der Atmosphäre überraschend schnell zu. Die schnelle Zunahme hängt damit zusammen, dass während der El Niño-Phasen (aber auch anderer klimatischer Extremereignisse) gehäuft auftretende Brände und andere Störungen schnell viel Kohlenstoff freisetzen – und so die langfristige, vergleichsweise langsame Kohlenstoffaufnahme der ungestörten Ökosysteme kompensieren. In der Ökologie ist dies bekannt als die sogenannte „slow-in, fast-out-Dynamik“ des Kohlenstoffkreislaufs. Die langfristige Konsequenz davon ist, dass sich Veränderungen in der Häufigkeit von El Niños auf den CO2-Gehalt der Atmosphäre auswirken und so eine Rückkopplung zum Klimawandel verursachen können.

Das Team von Sönke Zaehle möchte mit seiner Arbeit vor allem dazu beitragen, künftige Klimamodelle zu verbessern: „Um verlässlichere Prognosen für die Zukunft zu machen, ist es entscheidend, die räumliche und zeitliche Dynamik der Kohlenstoffsenken möglichst genau zu kennen“, sagt Zaehle. Das gilt auch für Strategien, die auf Klimaneutralität abzielen: Der europäische „Green Deal“ etwa, der Netto-Null-Emissionen bis zum Jahr 2050 anstrebt (s. Geomax 29), kalkuliert die Kohlenstoffaufnahme durch Landökosysteme wie Wälder mit ein. Doch auch in unseren Breiten verlieren Wälder zunehmend ihre Fähigkeit, Kohlenstoff zu speichern: Im Jahr 2022 etwa wurden in Europa rekordverdächtige Temperaturen gemessen. Fast 30 Prozent des Kontinents – insgesamt rund drei Millionen Quadratkilometer – waren von einer schweren Sommertrockenheit betroffen. Ein Forschungsteam unter Beteiligung des Max-Planck-Instituts für Biogeochemie wies nach, dass die Netto-Kohlenstoffaufnahme der Biosphäre in diesem Gebiet stark verringert war. Einige Wälder in Frankreich setzten im Sommer durch Trockenstress und Waldbrände sogar Kohlenstoff frei. „Solche temporären Schwankungen der Kohlenstoffsenken werden bislang kaum berücksichtigt“, sagt Zaehle. Ein Ziel des europäische Erdbeobachtungsprogramms Copernicus ist es daher, die Kohlenstoffbilanz kontinuierlich zu überwachen.

Studien wie die der Jenaer Wissenschaftlerinnen und Wissenschaftler zeigen, wie fragil die natürlichen Kohlenstoffsenken sind. Dass wir uns auch weiterhin auf sie verlassen können, ist keineswegs sicher: „Inwieweit die terrestrischen Kohlenstoffsenken ihre Funktion als Klimapuffer in Zukunft noch erfüllen können, ist unklar“, sagt Santiago Botía. „Bei der derzeitigen globalen Erwärmung sind extreme Dürrejahre häufiger zu erwarten und werden wohl Teil der neuen Normalität“. Es ist daher entscheidend, dass wir uns auf diese Veränderungen vorbereiten und die Funktion der Ökosysteme erhalten. „Wichtig ist, die natürlichen Kohlenstoffsenken zu stärken – zum Beispiel durch Aufforstung von Wäldern, die Wiedervernässung von Mooren und eine nachhaltige Landwirtschaft, die den Kohlenstoffgehalt von Böden erhöht und weniger Treibhausgase produziert“, sagt Sönke Zaehle. „Neben dem Erhalt der natürlichen Senken ist aber eine Reduzierung der fossilen Emissionen unerlässlich, um den Klimawandel zu stoppen. Jede Tonne Kohlenstoffdioxid, die wir vermeiden, zählt.”

Die sogenannte El Niño-Südliche Oszillation (ENSO) ist ein gekoppeltes Zirkulationssystem von Ozean und Atmosphäre im tropischen Pazifik. Normalerweise schieben die Passatwinde das Oberflächenwasser entlang des Äquators von der Westküste Südamerikas in Richtung Südostasien. Dort steigt der Meeresspiegel infolgedessen um gut einen halben Meter an. Vor Südamerika erzeugt diese westwärtige Strömung einen Sog, der kaltes Tiefenwasser zur Oberfläche strömen lässt. Das kalte Wasser heizt sich auf dem Weg nach Westen auf, was vor Südostasien für starke Verdunstung und ein regenreiches Klima sorgt. Etwa alle fünf Jahre passiert es, dass sich die Passatwinde aufgrund von Veränderungen der Luftdruckverhältnisse über dem Pazifik abschwächen oder ihre Richtung sogar umkehren. Dadurch strömt warmes Wasser aus dem Westpazifik nach Osten. An der sonst trockenen Westküste Südamerikas kommt es dadurch zu starken Niederschlägen, während in Südost-asien weniger Regen fällt. Weil das Phänomen seinen Höhepunkt typischerweise um Weihnachten erreicht, wird es El Niño, spanisch „das Christkind“, genannt.

Abbildungshinweise:

Titelbild: © P. Papastefanou / MPI-BGC

Abb. A: © Author: Oeneis; Data from Dr. Pieter Tans, NOAA/ESRL and Dr. Ralph Keeling, Scripps Institution of Oceanography / CC BY-SA 4.0

Abb. B: © Global Carbon Project; Data source: Friedlingstein et al. 2023 Global Carbon Budget 2023. Earth System Science Data. // CC BY 4.0; https://globalcarbonatlas.org

Abb. C: © S. Botía, MPI für Biogeochemie / CC BY 4.0

Der Text wird unter CC BY-NC-SA 4.0 veröffentlicht.

GEOMAX Ausgabe 30, Februar 2025; Text: Tim Kalvelage; Redaktion: Elke Maier, Tanja Fendt

Der Klimawandel hinterlässt seine Spuren: Dürren und Starkregen im Wechsel beeinflussen die Qualität unseres Grundwassers, weil die ausgetrockneten Böden das Regenwasser schlechter filtern. Ein Gespräch mit Gerd Gleixner vom Max-Planck-Institut für Biogeochemie in Jena.

Themen im Podcast:

min 1:50 Wie gefährden Extremereignisse unser Trinkwasser?

min 2:50 Standorte für die Probenentnahme

min 4:14: Verwendete Messtechniken

min 5.24: Ergebnisse der Forschung

mih 6.30: Auswirkung des Hitzejahres 2018

min 8:08: Welche Stoffe gelangen ins Trinkwasser?

min 11:00: Auswirkungen / Folgerungen

min 13:40: Nächste Schritte in der Forschung

Zum Podcast (16 min) vom 6. Februar 2025 © detektor.fm / Max-Planck-Gesellschaft

Hintergründe zur Langzeitstudie

Foto: © Drbouz / istock

Ammoniak ist unentbehrlich zur Herstellung von Düngemitteln. Erzeugt wird es nach dem Haber-Bosch-Verfahren aus Stickstoff und Wasserstoff. Forschende suchen auch nach geeigneten Katalysatoren für die Rückreaktion, also die Zerlegung von Ammoniak. Denn das Molekül soll als Träger für Wasserstoff dienen, der auf regenerativem Weg in sonnen- oder windreichen Staaten erzeugt werden soll. Claudia Weidenthaler vom Max-Planck-Institut für Kohlenforschung erklärt Wissenschaftsjournalist Hellmuth Nordwig, was einen guten Katalysator ausmacht, wie Forschende Katalysatoren für die Ammoniakzerlegung suchen – und warum es gar nicht so einfach ist, einen geeigneten zu finden.

Audiodatei | 20 min, Januar 2025

© MPG / CC BY-NC-ND 4.0